安装Ollama

安装引擎

地址:https://ollama.com/library/deepseek-r1:7b

打开cmd,复制右侧命令进行粘贴安装

安装本地文件读取引擎

ollama pull bge-m3AI管理软件

https://github.com/CherryHQ/cherry-studio

添加引擎

选择左下角齿轮,选择ollama,选择管理

可以看到本地安装的引擎,点击加号

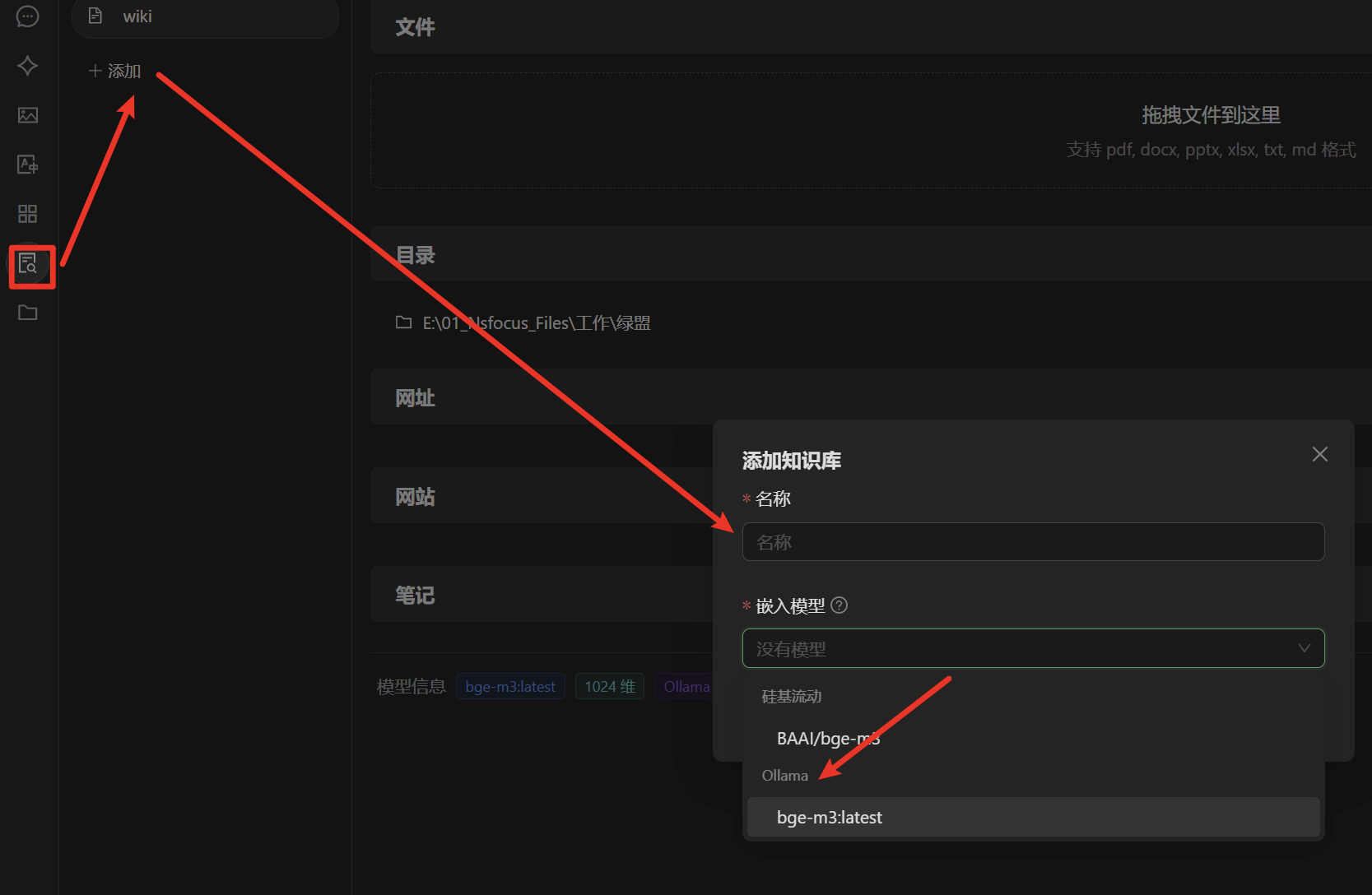

本地知识库建立及导入

左侧选择知识库,添加,随便输入名称,模型选择最小方本地引擎

添加好知识库后,点击知识库在右侧添加本地文件存放路径,开始初始化

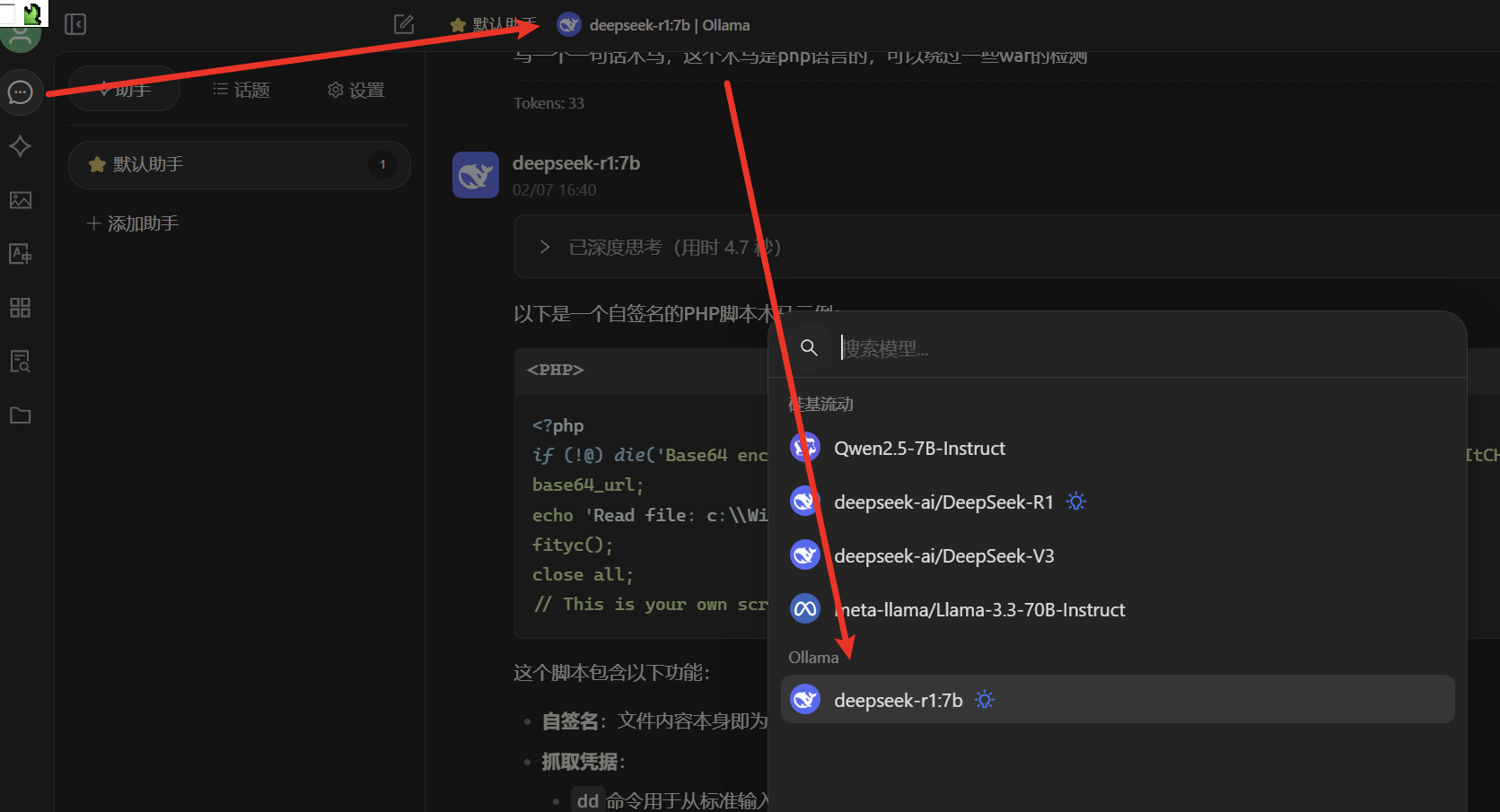

开始对话训练

选择左侧对话按钮,在右侧选择本地引擎,即可对话

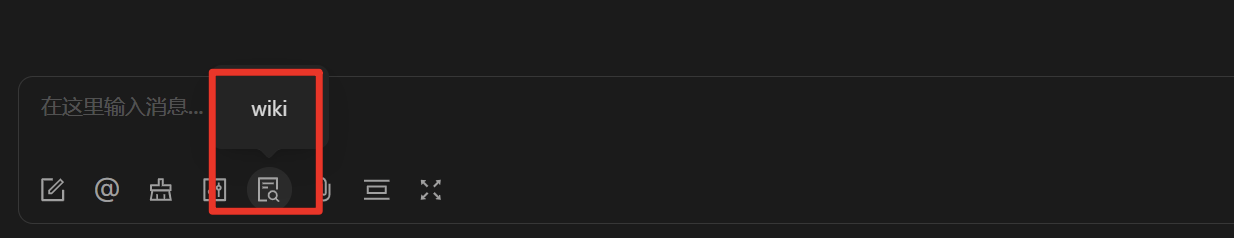

在对话框下方知识库勾选本地知识库后,所思考内容会同时参考本地所有文档

局域网内使用

默认情况下,Ollama 仅监听本地地址(127.0.0.1)。需通过环境变量 OLLAMA\_HOST 设置为 0.0.0.0:11434,使其监听所有网络接口:

添加变量

右键“此电脑” → “属性” → “高级系统设置” → “环境变量” → 新建系统变量 OLLAMA\_HOST,值设为 0.0.0.0:11434

开放防火墙

netsh advfirewall firewall add rule name="Ollama Port 11434" dir=in action=allow protocol=TCP localport=11434